O artigo é uma transcrição adaptada de parte da aula “Moderação de conteúdo, automatização e liberdade de expressão” da profa. Fernanda Rodrigues para o Ciclo Formativo – Antirracismo e Políticas na Inteligência Artificial e TICs.

As normas em disputa e construção sobre processos de moderação de conteúdo globalmente vão servir para delimitar o que as plataformas podem fazer, quais são os prazos, critérios de notificação dos usuários e afins. Nessa contribuição, vou ligar o debate à proposição do Projeto de Lei 2.338, voltado à regulação de sistemas de inteligência artificial no Brasil, que foi uma minuta substitutiva elaborada pela Comissão de Juristas do Senado, composta para essa finalidade.

Partindo da posicionalidade de uma pesquisadora com graduação e mestrado em Direito, e que também realiza doutorado na disciplina, vou naturalmente ter esse pano de fundo, mas farei um esforço consciente para sair do “juridiquês” e dos vícios da estrutura jurídico-normativa em nossa conversa. O fio central em nosso papo é discutir o que é possível fazer, realmente, quando a gente se depara com violações causadas à liberdade de expressão pela própria moderação de conteúdo?

Geralmente, a moderação vem para nos ajudar a reverter violações da liberdade de expressão – tais como discurso de ódio -, mas a própria moderação pode, em alguns casos, ser a manifestação da violação da liberdade de expressão. O que podemos fazer ao nos deparar com uma situação como essa? O Direito não é a resposta para tudo, mas podemos evocar mecanismos que podem ser operacionalizados.

Como a gente tem essas ferramentas, esses instrumentos à nossa disposição, é importante a gente saber como operacionalizar isso a nosso favor quando a gente sofre algum tipo de violência ou violação de direitos na internet. Tudo isso sempre a partir de um ponto de vista racializado. Todas as minhas pesquisas individuais, principalmente a partir do final da graduação até hoje, elas sempre se direcionaram a partir de uma perspectiva racializada. A perspectiva que eu trago hoje é essa também para a gente conseguir falar sobre moderação de conteúdo.

Como o objetivo aqui é ser um ciclo formativo, eu resolvi trazer o que a gente entende por moderação de conteúdo primeiro, para partirmos de uma base comum. Trago a referência a seguir, que é um livro que eu escrevi junto com a Júlia Caldeira, pesquisadora e líder de projeto no IRIS, no qual realizamos uma série de entrevistas com especialistas sobre diversos aspectos a respeito da moderação de conteúdo.

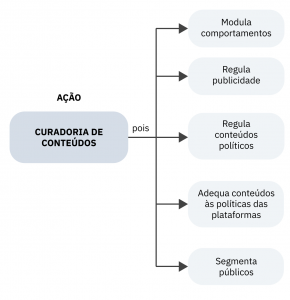

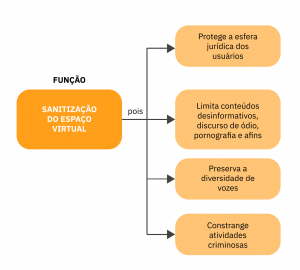

Governança da moderação de conteúdo online: percepções sobre o papel dos atores e regimes é um documento extenso porque foram muitas contribuições com entrevistas que geraram muita informação rica, então foi difícil deixar qualquer parte de fora. Uma das contribuições que a gente mais gostou, se dá para escolher alguma, se relaciona a uma das perguntas que fizemos a todas as pessoas entrevistadas, sobre o que tais especialistas entendiam como moderação de conteúdo. Perguntamos quais atividades realizadas eram consideradas moderação de conteúdo e quais ações essa atividade englobava. Na imagem a seguir, que foi resultado do relatório, podemos ver quais as funções dessa moderação de conteúdo e como as ações mencionadas foram vistas como ações finais. Assim, surgiram dois aspectos principais.

O primeiro seria a moderação como curadoria de conteúdos. Aqui a moderação de conteúdo é realizar a seleção de conteúdos que são disponibilizados na plataforma, o que pode modular comportamentos, regular a publicidade, regular conteúdos políticos e outros. Assim, essa curadoria é aquela que vai definir o que aparece primeiro na nossa timeline do Instagram, do Facebook, Twitter, dentre outros. Ela é também o que vai definir qual tipo de anúncio aparece para a gente. E tudo isso, de alguma forma, também impacta em como nos comportamos nesses espaços e até no mundo físico mesmo. Então, a moderação pode modular esses comportamentos. E essa curadoria também segmenta públicos, para quem ela vai se destinar, de que forma ela vai impactar determinados públicos, e ela também adequa esses conteúdos às políticas de plataformas.

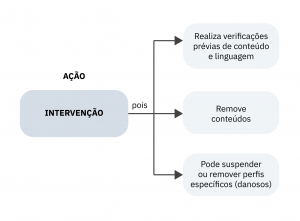

Por outro lado, a moderação de conteúdo enquanto intervenção é a que a gente mais fala corriqueiramente, me parece. Justamente, acontece quando a plataforma vai intervir diretamente em cima de um conteúdo, seja porque ele é nocivo, seja porque está descumprindo alguma política daquele espaço. Então, essa moderação realiza verificações prévias de conteúdo e linguagem, remove postagens, suspende ou remove contas também. Isso tudo foi encarado como uma atividade de moderação de conteúdo nas falas das pessoas entrevistadas em nosso estudo. Junto disso, a gente perguntou também, então, qual era a função? A rigor, para que a plataforma está lá removendo aquele conteúdo? E aí, as principais respostas foram que seriam duas funções.

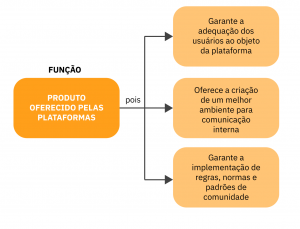

A primeira, como função de produto oferecido pelas plataformas. Pode-se dizer que ela é um produto que as plataformas oferecem, na medida em que é vantajoso para uma plataforma X dizer que ela faz uma boa moderação de conteúdo. Porque isso significa que aquele espaço online dela é interessante para as pessoas estarem ali, que permite a conversa, o diálogo adequado entre as pessoas, sem ofensas. A plataforma pode alegar que oferece a criação de um melhor ambiente para a comunicação e garante a adequação dos usuários ao objeto da plataforma, garantindo a implementação de regras, normas e padrões de comunidade.

A outra função principal seria a sanitização do espaço virtual. Significa fazer a remoção de conteúdos indesejáveis, no sentido de limitar conteúdos desinformativos, proteger a esfera jurídica dos usuários, preservar a diversidade de vozes e constranger atividades criminosas. Aqui, preservar a diversidade de vozes é a questão: podemos nos questionar se realmente isso acontece ou não.

Agora que entendemos quais são as principais noções de moderação de conteúdo e como atores compreendem essa moderação, falaremos sobre aspectos econômicos e políticos de tais atividades na próxima parte da série.

Fernanda Rodrigues – Coordenadora de pesquisa e Pesquisadora do Instituto de Referência em Internet e Sociedade (IRIS). Doutoranda em Direito pela Universidade Federal de Minas Gerais (UFMG). É Mestre em Direitos da Sociedade em Rede e Graduada em Direito pela Universidade Federal de Santa Maria (UFSM). Membra do Coletivo AqualtuneLab. Tem interesse em pesquisas na área de governança e racismo algorítmicos, reconhecimento facial e moderação de conteúdo.

Assine nosso boletim para ser avisado dos próximos textos da série

Deixe um comentário