Texto por Carla Vieira, mestre em Inteligência Artificial pela USP, Engenheira de Dados e professora do curso Racismo Algorítmico, de acesso gratuito e aberto.

Nos últimos tempos, a Inteligência Artificial Generativa ganhou bastante destaque na mídia e seu uso se popularizou muito no mundo todo. Diariamente, são reportados por usuários através das redes novos incidentes discriminatórios relacionados ao uso de sistemas algorítmicos baseados em IA Generativa, desencadeando uma forte discussão pública sobre o tema nos últimos meses.

Além disso, é importante destacar que esses sistemas não estão sendo apenas acessados por milhões de usuários, como estão sendo incorporados aos produtos de grandes empresas por meio de uma estratégia agressiva de comercialização das Big Techs. Logo, é crucial discutir como essa tecnologia pode perpetuar estereótipos e preconceitos em uma escala exponencial e dar visibilidade para a população sobre os potenciais riscos. Construir uma sociedade resiliente à Inteligência Artificial através da educação tornou-se tão importante como nunca.

Os sistemas algorítmicos baseados em IA Generativa são construídos utilizando o que chamamos de Redes Neurais Adversárias (GANS). Esse tipo de rede neural tem como objetivo o aprendizado e geração de novos dados em diferentes formatos, como: textos, imagens, áudios, vídeos e etc. Mas, qual a diferença desse tipo de IA para as redes neurais que fazem classificação de imagens?

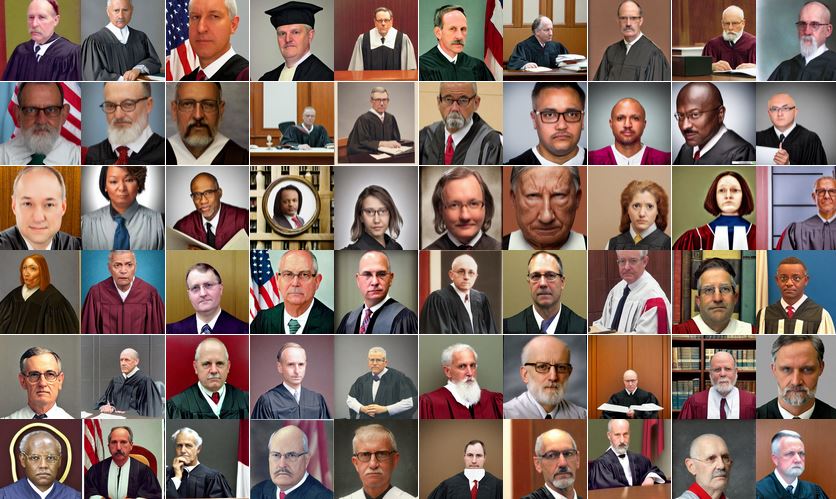

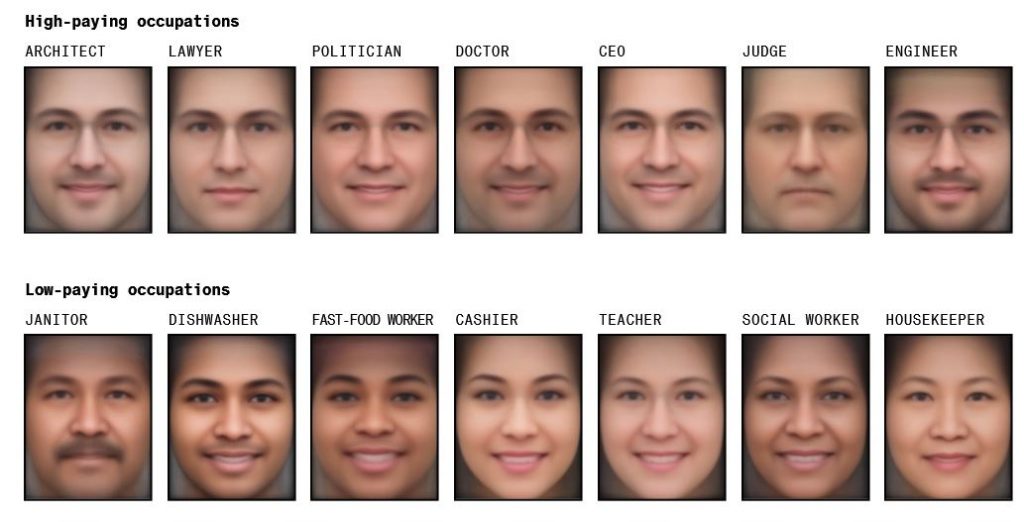

Diferentemente de algoritmos de classificação, as GANs não precisam de treinamento com dados rotulados de forma que essas redes conseguem aprender através de identificação de padrões e agrupamentos dentro do conjunto de dados.Nos últimos meses, relatos de usuários do mundo todo têm revelado as fragilidades dos modelos de IA Generativa (como ChatGPT, Midjourney, DALL-E entre outros). Uma matéria e pesquisa realizada pela Bloomberg, mostrou os resultados de geração de imagens de trabalhadores para 14 diferentes empregos (classificados de “alta remuneração” ou “baixa remuneração” nos EUA). Os resultados (Figura 1) relevam o racismo algorítmico enraizado nas tecnologias de forma que o modelo chegou a gerar imagens de pessoas com tons de pele mais escuros 70% das vezes para a palavra-chave “trabalhador de fast-food”, embora 70% dos trabalhadores de fast-food nos EUA sejam brancos.

A Hugging Face realizou testes de vieses semelhantes e disponibilizou a ferramenta para outros usuários. Em resposta, a OpenAI e Stability.AI, empresas que construíram o modelo Stable Diffusion, afirmam que introduziram correções para mitigar os preconceitos existentes em seus sistemas, como o bloqueio de certos prompts que possam gerar imagens ofensivas. No entanto, os estudos da Bloomberg e da Hugging Face mostram o quão limitadas são essas correções.

Esses relatos estão relacionados a grandes fragilidades existentes dentro de sistemas baseados em IA Generativa: (i) as bases de dados de treinamento, (ii) opacidade e (iii) veracidade de conteúdo.

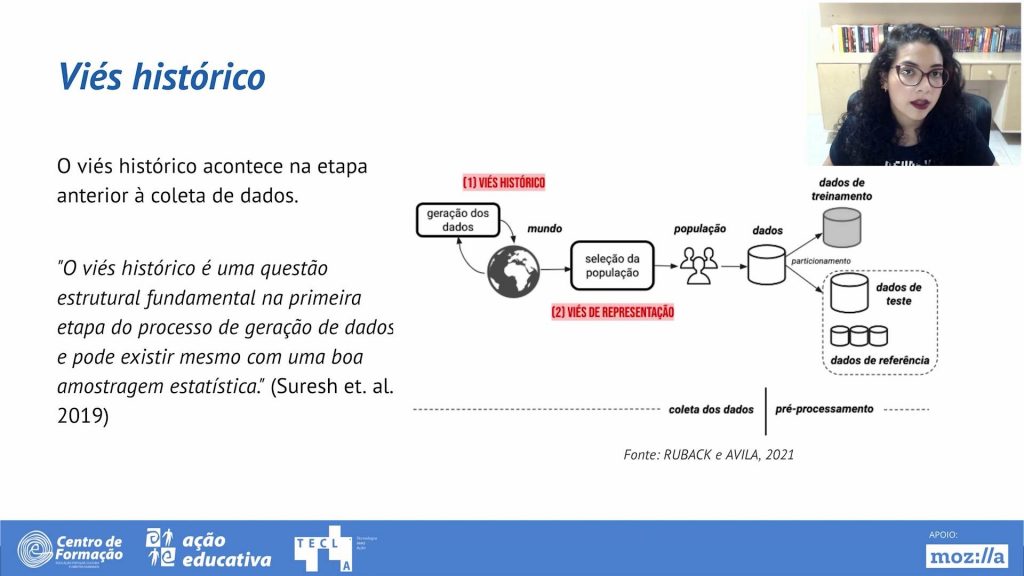

Os datasets utilizados para treinamentos de sistemas dessa magnitude são tão grandes que impossibilitam submetê-los a algum tipo de auditoria, para identificar, por exemplo, dados protegidos por direitos autorais e/ou propriedade intelectual, informações pessoais e confidenciais, violações de privacidade e/ou conteúdo impróprio e discriminatório. No caso da IA Generativa, os vieses são em grande parte inseridos justamente através dos dados de treinamento. Como a IA Generativa trabalha sob a premissa de encontrar padrões nos dados, esta pode incorporar estereótipos de gênero e preconceitos existentes nos dados de treinamento. Por exemplo, como o treinamento inclui textos e imagens que retratam pessoas negras em papéis estereotipados, os modelos continuam reforçando essas representações nos conteúdos gerados. Dessa forma, um viés histórico se faz muito presente.

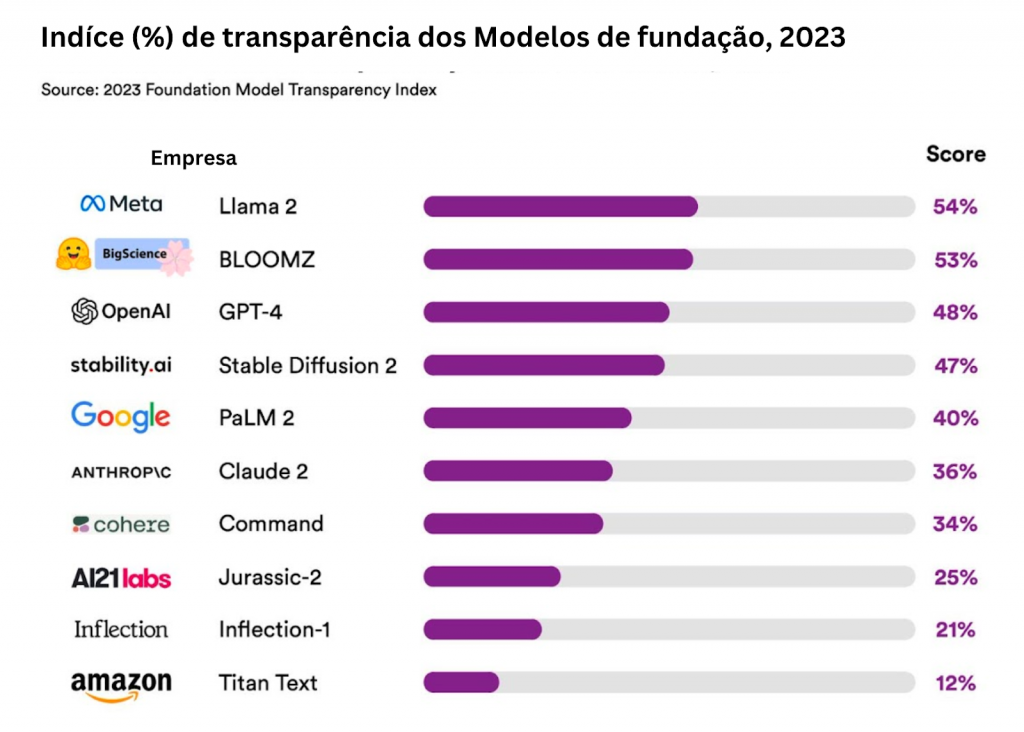

Um segundo ponto de fragilidade é a opacidade e falta de transparência dos algoritmos utilizados dentro da IA Generativa. Por exemplo, GPT-4 é composto por uma rede neural de 100 bilhões de neurônios distribuídos em mais de 100 camadas. Algoritmos dessa dimensão são eficientes, mas não explicáveis. Um estudo liderado pela Universidade de Stanford, analisou o nível de transparência dos chamados modelos de fundação (Figura 2) e identificou que existem muitos pontos para melhoria e que modelos open-source lideram o nível de transparência com relação a modelos proprietários.

Um terceiro ponto de fragilidade são os impactos desses modelos na propagação de informações falsas e não verificadas através de textos, vídeos, áudios e imagens. O desafio nesse contexto não é só o realismo das imagens e vídeos gerados, mas também a facilidade, escala e velocidade com que essas informações podem ser geradas.

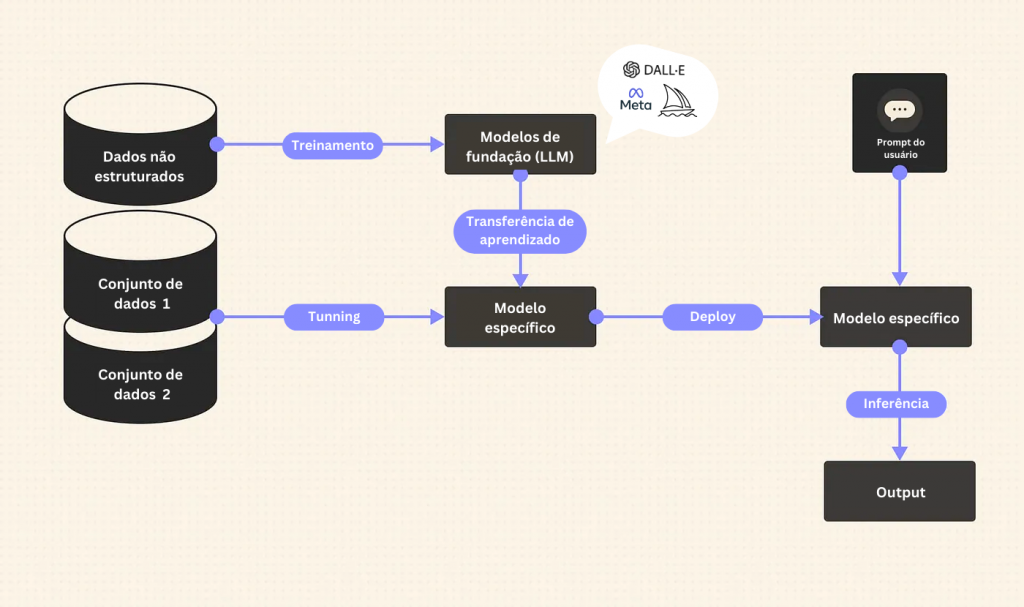

Considerando as fragilidades citadas, pode-se compreender que existem muitos desafios no uso de IA Generativa e que problemas conhecidos de privacidade, violação de direitos, racismo algorítmico e ética permanecem em novas tecnologias – apenas com uma roupagem diferente. Parte do problema é que mitigar vieses e preconceitos está relacionado à auditoria e transparência desses sistemas. No entanto, como já demonstrado grande parte são sistemas proprietários caixa-preta que tem tido seu uso facilitado e pulverizado no formato “plug and play” A imagem abaixo reflete um diagrama do padrão geralmente utilizado para criação de aplicações baseadas em nos “Foundation Models” de IA Generativa.

Caminhos futuros

Considerando o contexto do Brasil, um país com tantas desigualdades e problemas estruturais na educação, existe uma questão delicada que não pode ficar de fora da pauta: a importância de construir letramento digital e uma sociedade resiliente à Inteligência Artificial. Por “sociedade resiliente”, entende-se uma sociedade civil que é capaz de: (i) questionar novas tecnologias, (ii) denunciar danos algorítmicos e (ii) participar ativamente dos debates regulatórios. No entanto, esse cenário só é possível através da educação. Para que a IA seja realmente capaz de contribuir para a solução de grandes problemas da sociedade, é preciso capacitar as pessoas para que elas façam parte dessa construção e reconstrução de novas tecnologias considerando a diversidade e particularidades regionais do nosso país.

Acompanhe mais de Carla Vieira através do LinkedIn, Twitter e website, além da sua dissertação ”Uso de agrupamento para alcançar explicabilidade global de modelos de aprendizado de máquina”.

Estude sobre o tema com o curso Racismo Algorítmico, desenvolvido por Carla Vieira e Tarcizio Silva. Está disponível gratuitamente e com acesso imediato no portal EAD da Ação Educativa.